Minder dan een eeuw geleden stelde een Britse wiskundige zich een abstracte computer voor die zijn eigen geheugen zou uitlezen en dat nadien zou aanvullen met nieuwe informatie. Zou die wiskundige – genaamd Alan Turing – ooit hebben bevroed dat een artificiële intelligentie op een bepaald punt in de toekomst een geschiedenis zou schrijven over het ontstaan van AI? En dat die AI daarbij Turings werk als startpunt zou nemen?

Dat is exact wat de artificiële tekstgenerator GPT-3.5 onlangs heeft gedaan. Ook op andere vlakken heeft artificiële intelligentie prestaties afgeleverd die tot relatief recent onvoorstelbaar waren.

Een terugblik op de opvallendste ontwikkelingen van de afgelopen paar maanden.

1) Deze AI deed mee aan programmeerwedstrijden en ging niet compleet op zijn bek

Voor de eerste keer presteerde een artificiële intelligentie op competitief niveau in een programmeerwedstrijd.

Een eclatant succes zou je de prestatie van AlphaCode niet meteen noemen. Het nieuwe AI-model van DeepMind deed mee aan gesimuleerde programmeerwedstrijden en behaalde resultaten waarmee het ergens in de middenmoot van de menselijke deelnemers strandde. Goed zo, AlphaCode. Digitaal schouderklopje. Maar als we eerlijk zijn vonden we AlphaGo, toen die in 2016 de vloer aanveegde met Go-kampioen Lee Sedol, toch indrukwekkender.

Toch houdt DeepMind vol dat het wel degelijk een nieuwe mijlpaal heeft bereikt in artificiële intelligentie. Om die middelmatige score te behalen heeft AlphaCode namelijk bovenmaatse dingen gedaan. De AI heeft een in menselijke termen geformuleerd probleem correct geïnterpreteerd, is vervolgens met een algoritme op de proppen gekomen om dat probleem op te lossen én heeft eigenhandig code geschreven om het algoritme tot uitvoer te brengen. Dat alles samen is inderdaad wel straf.

Uiteraard bestonden er al AI-modellen die programmeerproblemen kunnen oplossen. Alleen ging het tot nog toe steeds om relatief eenvoudige klusjes. Vaak hadden ze weinig meer om het lijf dan een bepaald aantal stappen – voeg alle even nummers toe aan een lijst – omzetten naar lijntjes code.

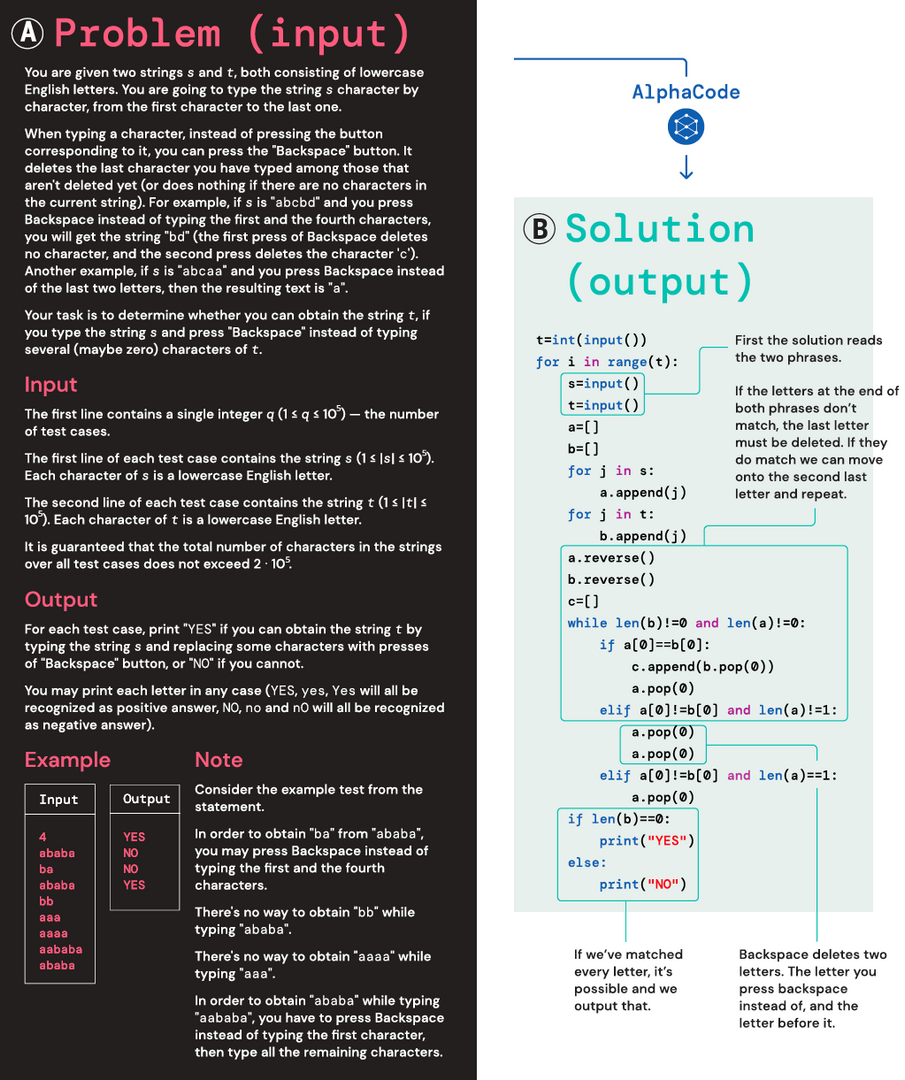

Wat AlphaCode heeft gedaan, is andere koek. Dit was een van de problemen waarvoor de AI een oplossing moest zoeken:

Uniek aan AlphaCode is dat de onderzoekers het model specifiek ontwierpen om programmeerproblemen zo goed mogelijk op te lossen. Om te beginnen voedden ze het met 715 gigabytes aan code, geschreven door menselijke programmeurs. Lijntjes code werden willekeurig in twee helften gesplitst, waarna de AI op basis van de ene helft de andere moest vinden.

Vervolgens kreeg het model nog eens een brok van 2,6 gigabyte aan data te verteren. Deze dataset bestond uit problemen met menselijke oplossingen – juiste maar ook foutieve – die de onderzoekers hadden opgediept uit programmeerwedstrijden. Op dit punt begon AlphaCode zelf oplossingen te presenteren, maar dan met hele hopen bij elkaar, en niet allemaal correct.

In een laatste fase trainde AlphaCode zichzelf om uit de vele mogelijke oplossingen te filteren en een kleine set aan mogelijke oplossingen over te houden. Met een ongezien succes: de AI kan problemen oplossen die het model nooit eerder zag, en waar best wat redeneervermogen bij komt kijken. Dat de AI zichzelf daarbij niet noodzakelijk ‘begrijpt’, staat het proces niet in de weg.

Het systeem kan de productiviteit van programmeurs gevoelig verhogen, zeggen de onderzoekers. Het zou zelfs hun hele werkproces kunnen veranderen. In plaats van zelf code te schrijven om een gegeven probleem op te lossen, kunnen programmeurs in de nabije toekomst een probleem formuleren en het codeerwerk overlaten aan artificiële intelligentie.

2) De opvolger van tekstgenerator GPT-3 ‘hallucineert’ een stuk minder

Tekstgenerators worden nauwkeuriger, verbaler en gevatter.

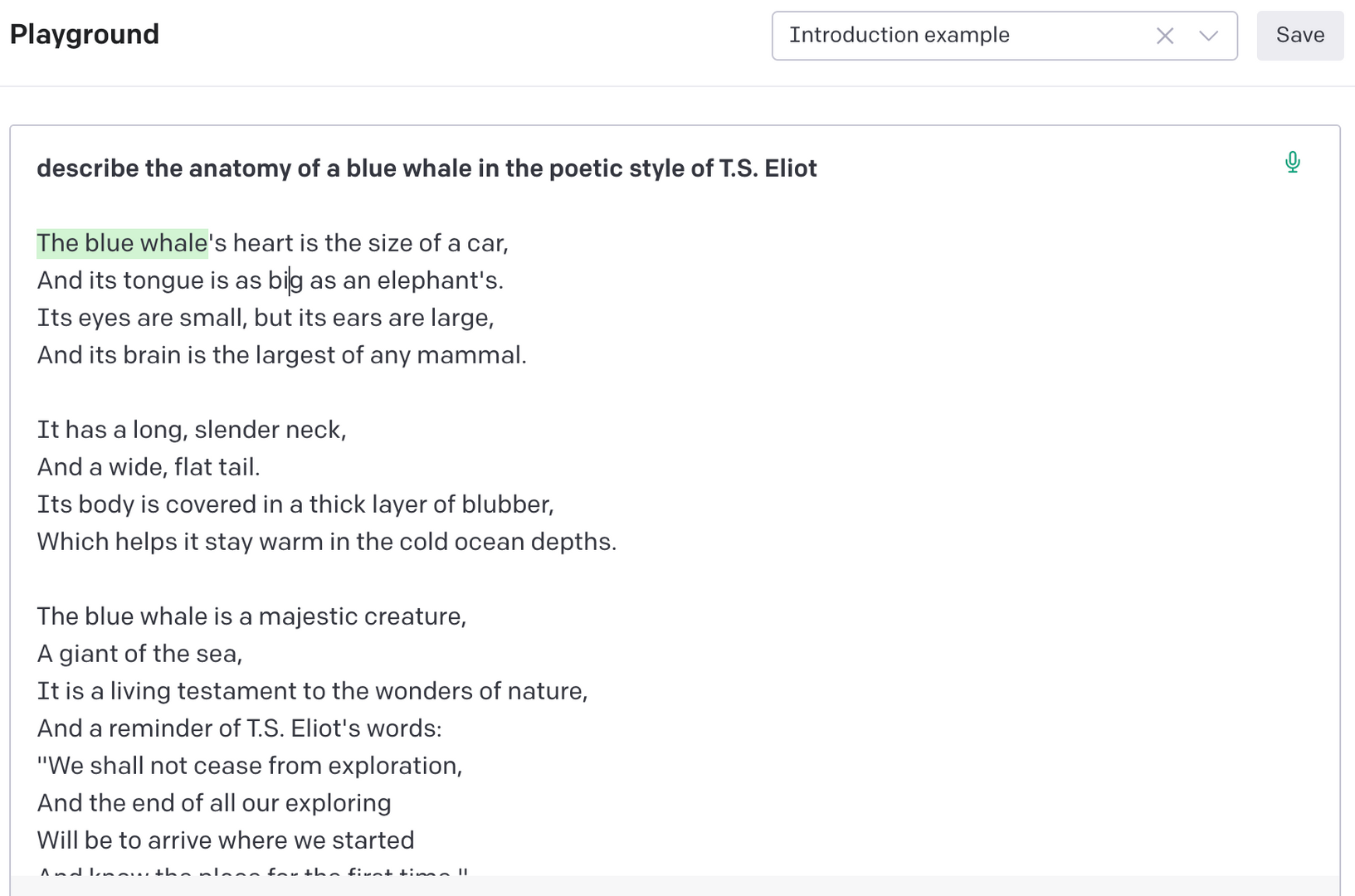

Hij kan de basisbeginselen van quantumfysica uitleggen in de stijl van rapper Snoop Dogg, maakt mopjes met een echte pointe, én is een stuk kritischer voor toxische of sterk bevooroordeelde input van gebruikers. Amper een week nadat OpenAI de geüpdatete versie van GPT-3 had aangekondigd, hebben al meer dan een miljoen nieuwsgierigen gebruik gemaakt van GPT-3.5. En uit die gebruikerservaringen komt naar voren dat de als chatbot verpakte tekstgenerator op zowat alle vlakken beter is.

GPT-3.5 is een neuraal netwerk dat teksten genereert op eenvoudig verzoek. Als gebruiker geef je een input – zoals: beschrijf de anatomie van de blauwe vinvis in de poëtische stijl van T.S. Eliot – en de AI schrijft je een tekst die zo goed mogelijk aan de opdracht beantwoordt. Andere tekstgenerators – waaronder voorganger GPT-3 – konden dat ook al. Maar deze AI doet het allemaal net iets beter.

De AI lijkt vooral veel meer rekening te houden met de context achter een verzoek, zeggen gebruikers. Dat komt de kwaliteit van de teksten ten goede. Die teksten zijn trouwens gemiddeld 65 procent langer dan wat voorganger GPT-3 bij dezelfde verzoeken genereerde. Bovendien ‘hallucineert’ de AI een stuk minder dan eerdere modellen: hij schrijft consistenter, en zijn teksten bevatten minder feitelijk incorrecte beweringen.

Net als GPT-3 en andere tekstgenerators werd GPT-3.5 getraind om de verbanden te zien tussen zinnen, woorden en woorddelen. Ingenieurs van OpenAI gaven het model honderdduizenden Wikipedia-pagina’s te verteren, samen met gigantische hoeveelheden nieuwsartikels en sociale-mediaberichten.

Hoe OpenAI erin geslaagd is om GPT-3.5 zoveel verfijnder te maken dan GPT-3, is onduidelijk. Wellicht heeft het te maken met de feedback die het model kreeg van zijn menselijke ‘trainers’.

3) Schaakmat voor de mens

AI-modellen worden steeds beter in spelletjes spelen, en dat kan gunstige gevolgen hebben voor praktische toepassingen.

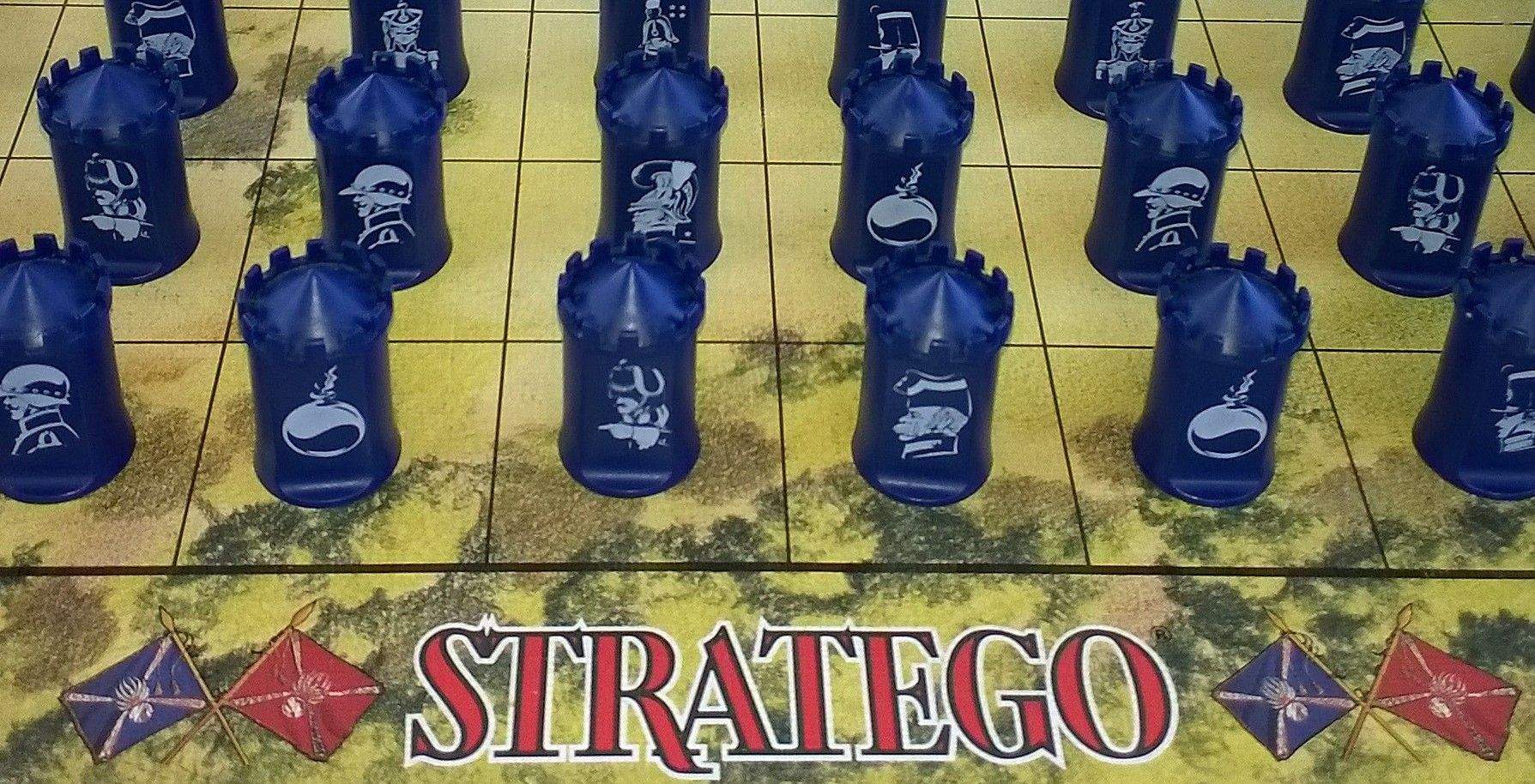

Eerst was het schaken, dan Go, en daarna poker. In steeds meer spelletjes moeten mensen de duimen leggen tegen artificiële intelligentie. Die lijst is recent uitgebreid met Stratego en Diplomacy.

Dat een AI het haalt van een menselijke expert in een spelletje Stratego is eigenlijk veel indrukwekkender dan een soortgelijke prestatie in schaken. Stratego is op bepaalde vlakken namelijk een stuk complexer. In het oorlogsspel plaatsen twee spelers elk veertig pionnen op een bord. Ze kunnen enkel de eigen stukken zien. Elk om beurt mogen ze een stuk verplaatsen. De ene pion elimineert de andere als die eerste een hogere rang heeft. De speler die de vlag aan de andere kant van het bord verovert, wint.

Het ogenschijnlijk simpele spelletje kan op 10535 mogelijke manieren worden gespeeld – nog heel wat meer dan Go (10360). En lang niet elk spelverloop is volledig gedicteerd door rationele keuzes van de spelers. Toch is DeepNash, een AI ontwikkeld door DeepMind, erin geslaagd om voor al die mogelijke manieren de beste speelstrategie te vinden. Het heeft daarvoor liefst 5,5 miljard spelletjes tegen zichzelf gespeeld. Bij elke foute zet paste de AI de eigen parameters aan.

Al dat werk heeft zijn vruchten afgeworpen. DeepNash nam het op een online platform op tegen echte, menselijke spelers. Na vijftig spelletjes stond de AI al op de derde plaats in de ranking van alle spelers op het platform sinds 2002.

Minstens even indrukwekkend is hoe een AI het haalde van mensen in het spelletje Diplomacy. De AI in kwestie heet Cicero en werd ontwikkeld door onderzoekers verbonden aan Meta – voorheen bekend als Facebook. Cicero trainde zichzelf met 126.261 online spelletjes tussen menselijke spelers, gecombineerd met virtuele spelletjes tegen zichzelf. Na veertig potjes met echte spelers belandde Cicero in top 10 procent van spelers die het spel meer dan één keer hebben gespeeld.

Het verrassende daaraan is dat Diplomacy in wezen een groepsspel is, waarbij onderling strategisch overleg tussen de tot wel zeven spelers cruciaal is voor het spelverloop.

In de nabije toekomst kunnen soortgelijke AI’s zeer nuttig blijken voor praktische toepassingen. ‘Als je een zelfrijdende auto bouwt mag je er niet van uitgaan dat alle andere bestuurders op de weg zich altijd perfect rationeel gedragen’, zegt Meta-onderzoeker Noam Brown in het tijdschrift Nature. ‘Met de specifieke intelligentie van deze AI’s aan boord kan een zelfrijdende auto wellicht veel beter reageren in minder voorspelbare omstandigheden.’

4) AI forceert onontdekte moleculen om zichzelf prijs te geven

Op amper twee weken tijd kon een AI-model de structuren van 617 miljoen eiwitten voorspellen.

Elke cel van ons lichaam bevat miljarden eiwitten. Ze voeren de informatie uit die in onze genen gecodeerd zit. Op die manier zorgen ze er bijvoorbeeld voor dat onze ogen licht kunnen waarnemen, of vuren ze onze zenuwcellen aan. Welk eiwit nu precies wat doet, heeft te maken met hoe die eiwitten zichzelf opvouwen tot een unieke driedimensionale structuur.

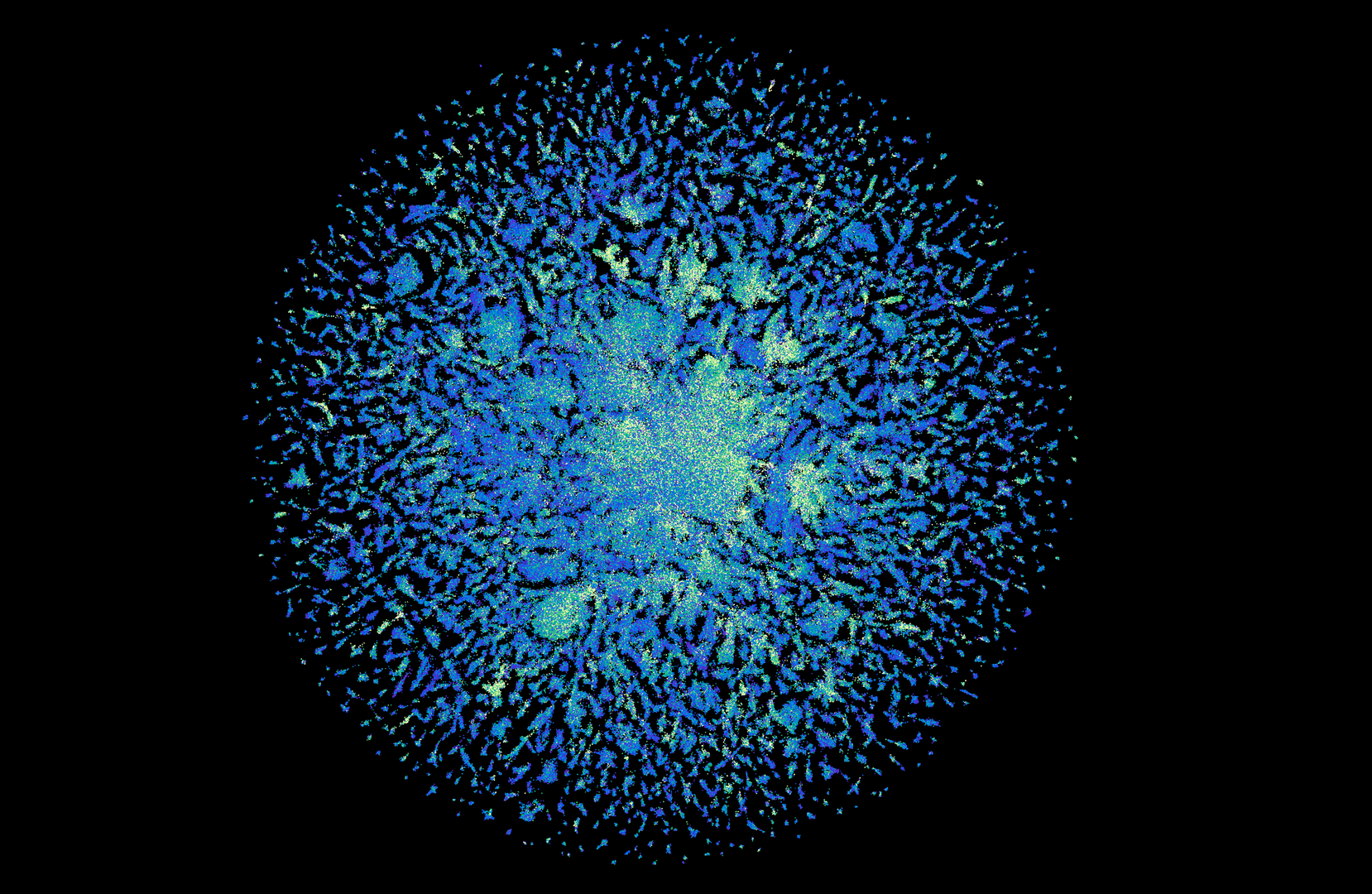

Eerder dit jaar kon DeepMind met het AI-model AlphaFold voor het eerst de 3D-structuren voorspellen van zowat alle 220 miljoen eiwitsoorten die wetenschappers tot nog toe hebben waargenomen in levende organismen. Het was een doorbraak in de microbiologie. Vandaag, amper zes maanden later, is een ander bedrijf de nog onontdekte ‘donkere materie’ van het eiwittenuniversum in kaart aan het brengen.

Onderzoekers van Meta ontwikkelden een AI-model dat de structuren kon voorspellen van grofweg 600 miljoen nieuwe, tot dan toe onbekende eiwitten. Het gaat om eiwitten van bacteriën, virussen en andere micro-organismen.

De eiwitten van zulke bacteriën en virussen – maar ook die van alle andere levende wezens – bestaan uit lineaire ketens van aminozuren. Die ketens kun je neerschrijven als een reeks letters. Dat is precies wat de Meta-onderzoekers deden: ze namen de aminozuurketens van enkele bekende eiwitten, zetten die om naar letters en maakten enkele van die letters onleesbaar. Met die onvolledige reeksen voedden ze hun AI-model, zodat het zichzelf kon aanleren hoe het onleesbare letters het best aanvult.

In een tweede stap gaven de onderzoekers het model informatie mee over onderlinge verbanden tussen bekende eiwitstructuren en aminozuurketens. Daarna lieten ze hun AI los op een databank van eDNA-monsters: stukjes DNA die organismen achterlieten in de bodem, in zeewater, op onze huid en in onze darmen.

Na twee weken zwoegen, zweten en berekenen had het AI-model liefst 617 miljoen eiwitstructuren voorspeld. Het overgrote deel daarvan blijkt toe te wijzen aan eencelligen die tot dan toe onbekend waren voor wetenschappers. Meer dan een derde van die voorspellingen zijn van hoge kwaliteit – de onderzoekers hebben er vertrouwen in dat de voorspelde eiwitstructuren daadwerkelijk kloppen.

Hoe moeten we dit allemaal interpreteren?

‘We zien inderdaad heel wat vooruitgang in de wereld van artificiële intelligentie. Leeralgoritmes worden steeds beter en halen steeds meer uit trainingsdata’, zegt wiskundige Ann Dooms (VUB). ‘Met deze ontwikkelingen komen we weer wat dichter bij de grens van onze eigen capaciteiten.’ Modellen als AlphaFold kunnen wellicht leiden tot vaccins die we anders nooit hadden kunnen ontwikkelen, zegt Dooms.

‘Deze ontwikkelingen brengen ons weer wat dichter bij de grens van onze eigen capaciteiten’

Tegelijk wijst Dooms erop dat menselijk toezicht op dit punt onontbeerlijk blijft. ‘Wat deze AI-modellen doen, is statistiek op steroïden. Ze vertrekken steeds vanuit een bepaalde dataset, die ze al dan niet zelf verzamelen of aanmaken. Het betekent dat als er met die data iets loos is – de gegevens zijn bijvoorbeeld raciaal ongelijk gekleurd – de AI-modellen die lacunes in hun systeem overnemen, zonder dat ze zich van enig kwaad bewust zijn.’

De gevolgen daarvan waren laatst te zien bij GPT-3.5. ‘Aanvankelijk leek die update bijzonder indrukwekkend te zijn. Maar bij nader inzien blijkt ook GPT-3.5 vatbaar voor misconcepties die ontstaan uit ongebalanceerde datasets. Het gevaar bestaat dat fouten dan zelfs worden versterkt. Met AI staan we voor grote ontwikkelingen, maar evengoed ook voor grote uitdagingen.’