Met loeiende sirene raast een ambulance over de weg. Alle wagens gaan opzij, behalve eentje. Een zelfrijdende auto herkent het geluid niet. Voor het algoritme dat het bestuurt staat de ziekenwagen gelijk aan een gewone, grote witte wagen, zoals een bestelwagen.

Het scenario stond vorig jaar beschreven in een onderzoek van ingenieurs aan het Massachusetts Institute of Technology en Microsoft. Om het op te lossen, moesten de ingenieurs ingrijpen in de simulatietraining die zelflerende algoritmes krijgen voor ze naar het systeem van een autonome auto worden geüpload. Menselijke deelnemers moesten de simulatie meevolgen en manueel ingeven wanneer ze een ambulance zagen.

Uit het onderzoek komen twee kwetsbaarheden naar boven waarmee AI te kampen heeft. Enerzijds werd de zelfrijdende auto onvoldoende getraind. Anderzijds kunnen de sensors die in de wagen zijn ingebouwd elk afzonderlijk prikkels waarnemen – visueel en auditief – maar koppelen ze die niet aan elkaar. Het zijn onwaarschijnlijke scenario’s waar we bij het ontwikkelen van kunstmatige intelligentie toch rekening mee moeten houden, want een klein foutje kan al gauw een groot probleem veroorzaken.

Zulke onwaarschijnlijke scenario’s maken het een zeer complexe opgave om artificiële intelligentie te programmeren. Omdat AI nog relatief jong is, zijn er veel kwetsbaarheden, en zijn ze erg divers. Bovendien is AI vatbaar voor fouten die van een andere aard zijn dan de fouten die wij als mensen doorgaans begaan. Programmeurs moeten dus anders denken.

Drie leerstrategieën

Om te kunnen nagaan waar het bij AI fout kan lopen, moet je weten hoe kunstmatige intelligentie dingen aangeleerd krijgt. AI beschikt immers niet over een brein met neuronen. Taken als wandelen of taal gebruiken leert het niet noodzakelijk op dezelfde manier als wij dat doen.

‘Grofweg zijn er drie methodes om kunstmatige intelligentie iets aan te leren’, zegt AI-expert Mieke De Ketelaere (imec). Een eerste leermethode is gesuperviseerd leren. Daarbij wordt onder menselijk toezicht data aan een algoritme gevoed. Dat algoritme trekt daar vervolgens lessen uit. ‘Als je honderden foto’s toont van verschillende katten, dan leert AI hoe een kat eruitziet en hoe het die in het vervolg kan herkennen.’

Kunstmatige intelligentie leert ook ongesuperviseerd. ‘Vergelijk het met hoe kleuters vormen leren herkennen’, zegt De Ketelaere. ‘Ze krijgen van de begeleider bijvoorbeeld een blad papier met daarop cirkels, driehoeken, vierkanten, enzovoort. Door bijvoorbeeld alle driehoeken rood te kleuren, leert het kind een onderscheid te maken. Dat gebeurt voor een stuk zelfstandig, zonder dat de meester of juf altijd over de schouder meekijkt.’

'AI lijkt tot op zekere hoogte op een peuter of kleuter, maar qua inlevingsvermogen kan het systeem zich niet meten aan een tweejarige' AI-expert Mieke De Ketelaere (imec)

Tenslotte is er gereïnforceerd leren. Het systeem leert doordat het wordt beloond als het een taak goed uitvoert. ’Dat gaat intrinsiek met vallen en opstaan.’

Die leermethodes klinken vanzelfsprekender dan ze zijn. Bovendien staat artificiële intelligentie niet op het niveau van een mens, zelfs niet op dat van een kleuter. ‘AI lijkt tot op zekere hoogte op een peuter of kleuter, maar qua inlevingsvermogen kan het systeem zich niet meten aan een tweejarige. Het mist ook een simpel redeneervermogen’, zegt De Ketelaere.

‘En waar kinderen opgroeien, blijft AI op die leeftijd steken.’ De Ketelaere maakt de vergelijking met een spelletje vier-op-een-rij. ‘Een peuter van twee begrijpt niet wat het moet doen. Een kleuter van vier weet dat het vier schijfjes van dezelfde kleur naast elkaar moet plaatsen, maar wordt boos als hij daarbij wordt gedwarsboomd. Een kind van zes heeft al wel een goed redeneringsvermogen en kan het spel vlot spelen.’

CEO is blank en mannelijk

Met leermethodes alleen krijg je een zelfrijdende auto niet op de weg. Artificiële intelligentie heeft ook lesmateriaal nodig. Met andere woorden: data.

Om bijvoorbeeld een softwarepakket dat sollicitanten screent te trainen, moet je het gegevens voeden. Programmeurs halen die uit de rijke geschiedenis van de mensheid. Alleen is die verre van rooskleurig. Voorbeelden van racisme en discriminatie zijn er genoeg, en dat weerspiegelt zich in de data waarmee algoritmes worden gevoed. Dat leidt tot verkeerd aangeleerd gedrag. Het algoritme krijgt van meet af aan een cognitieve bias mee.

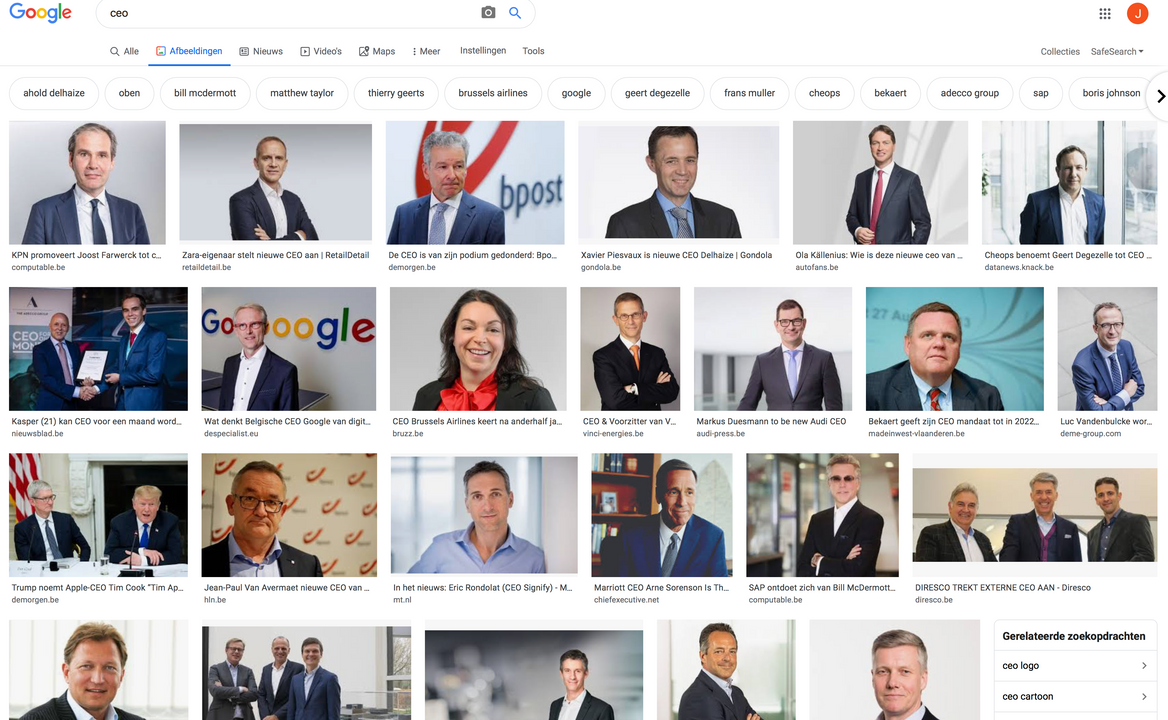

De voorbeelden van algoritmes die vrouwen en mensen met een getinte huidskleur discrimineren zijn talrijk. ‘Tik bij Google Images de zoekterm ‘CEO’ in, en je krijgt blanke mannen in een maatpak te zien’, zegt De Ketelaere.

Ook als de data op het eerste gezicht zuiver zijn, is het gevaar niet geweken. Gegevens zijn dikwijls erg afhankelijk van de context. Ze worden beïnvloed door culturen en normen. ‘In Australië liggen de waarden voor een te hoge bloeddruk bijvoorbeeld veel lager dan in België’, weet De Ketelaere. Een intelligente bloeddrukmeter van down under zou hier bijgevolg te snel bloeddrukverlagende medicatie aanraden.

Illustratie boven: zoekresultaten van 'CEO' bij Google Images.

‘We willen onmiddellijk resultaten. Daarbij verliezen we foutmarges uit het oog’

Bijkomend probleem is dat artificiële intelligentie het slachtoffer is van zijn eigen succes. Mensen verwachten veel van AI, en weigeren te wachten tot alles op punt staat. ‘Vaak wordt bij een nieuwe toepassing de testfase gewoon overgeslagen’, zegt De Ketelaere. ‘We willen onmiddellijk resultaten - de reactietijd die AI krijgt, is immens kort. Daardoor verliezen we foutmarges uit het oog. Bij systemen waarbij meerdere algoritmes op elkaar zijn aangesloten, ontstaat het risico dat een foutief model een ander, correct model corrumpeert. Dat noemen we model poisoning.’

Naar menselijk voorbeeld

Het menselijk lichaam heeft meerdere zintuigen. Inkomende waarnemingen worden gebundeld in één eindpunt: de hersenen. Dat werkt goed. Het lijkt logisch om AI op dezelfde manier op te bouwen. Toch is dat tot nog toe niet gebeurd.

Afhankelijk van de toepassing waarvoor ze wordt ingezet, krijgt kunstmatige intelligentie verschillende sensors, die elk apart prikkels waarnemen. De ene sensor vertelt een zelfrijdende auto welke vorm het voertuig achter hem heeft, terwijl de andere kan doorseinen of hij het geluid van een sirene detecteert. Die twee inputs samenvoegen en op z’n geheel interpreteren, lijkt nog niet dikwijls te gebeuren. Nochtans zou dat een AI-systeem veel slimmer maken.

Onderzoekers werken aan manieren om de menselijke zintuigen digitaal na te bouwen en te laten convergeren in een centrale, breinachtige node. Volgens De Ketelaere wordt daar momenteel veel vooruitgang in geboekt, maar staan nog niet alle ‘zintuigen’ op punt. Tot dan blijft menselijke input, zoals bij het scenario met de ambulance en de zelfrijdende auto, essentieel.