Naast teksten kan artificiële intelligentie nu ook beelden genereren. Wiskundige Ann Dooms legt uit hoe dat werkt.

Tot mijn grote spijt heb ik geen tekentalent. Ik kijk met stress terug op de lessen Plastische Opvoeding waar ik de opdracht wel in mijn hoofd zag, maar mijn hand niet uitvoerde wat ik voor ogen had. Gaat het om onhandigheid of zie ik wat ik wil tekenen eigenlijk niet nauwkeurig genoeg? Ook in een tekenprogramma lukt het me niet om tot een geslaagd resultaat te komen. Gelukkig kan ik tegenwoordig gebruikmaken van Google Images of online fotodatabanken om via tekst of vergelijkbare beelden te zoeken naar wat ik min of meer in gedachten heb. Natuurlijk ben ik dan wel afhankelijk van wat een ander al maakte. Mijn wildste fantasieën worden daarmee geen werkelijkheid.

Of toch wel? In januari lanceerde OpenAI, een Amerikaans onderzoekslab mee opgericht door Elon Musk, een opmerkelijk nieuw platform. Met wat tekstuele input toont het beelden die aan je beschrijving voldoen. Maar anders dan Google Images is dit geen zoekmachine die op het web speurt naar de gevraagde beelden. Het is een indrukwekkende toepassing van machine learning, waarbij het systeem de beelden zelf creëert. De ontwerpers noemden hun platform DALL-E, een knipoog naar de surrealistische schilder Dalí en de tekenfilmrobot WALL-E.

DALL-E is een toepassing van GPT-3, een softwaresysteem dat teksten genereert. Daarvoor maakt het gebruik van een neuraal netwerk dat op een ingenieuze manier en met bijzonder veel rekenkracht werd getraind met een enorm corpus aan voorbeeldteksten. Een deel van het netwerk krijgt een stuk zin voorgeschoteld en dient het volgende woord te voorspellen. Een ander deel checkt dan hoe goed die voorspelling was. Gradueel leert het netwerk zichzelf aan hoe het beter kan worden in zijn taak. Het resultaat is een taalmodel dat nieuwsberichten kan schrijven, en zelfs gedichten en hele romans. Dit model is het eerste dat taal werkelijk lijkt te begrijpen.

Alleen is dat niet zo. Dat merk je aan de ‘ongelukken’ in de output van het model. GPT-3 heeft heel wat teksten gegenereerd die geen steek houden. Soms gaat het om ludieke vergissingen, maar helaas blijkt de output ook vaak genderstereotiep of staan er andere pijnlijkheden in. Het model heeft die zaken natuurlijk geleerd uit het trainingsmateriaal dat het voorhanden had. De ontwikkelaars hadden dat wel kunnen voorzien.

Momenteel wordt er hard gewerkt om het systeem van zijn kinderziektes te genezen. Steeds vaker zien we minder gevaarlijke en ook gewoon leuke toepassingen opduiken. Onder die categorie valt dus DALL-E, waarvoor GPT-3 werd aangevuld met alweer een gigantische hoop aan voorbeelden. Deze keer bestonden die niet uit woorden en zinnen, maar uit foto’s. En als output genereert het GPT-3-model geen tekst, maar beelden.

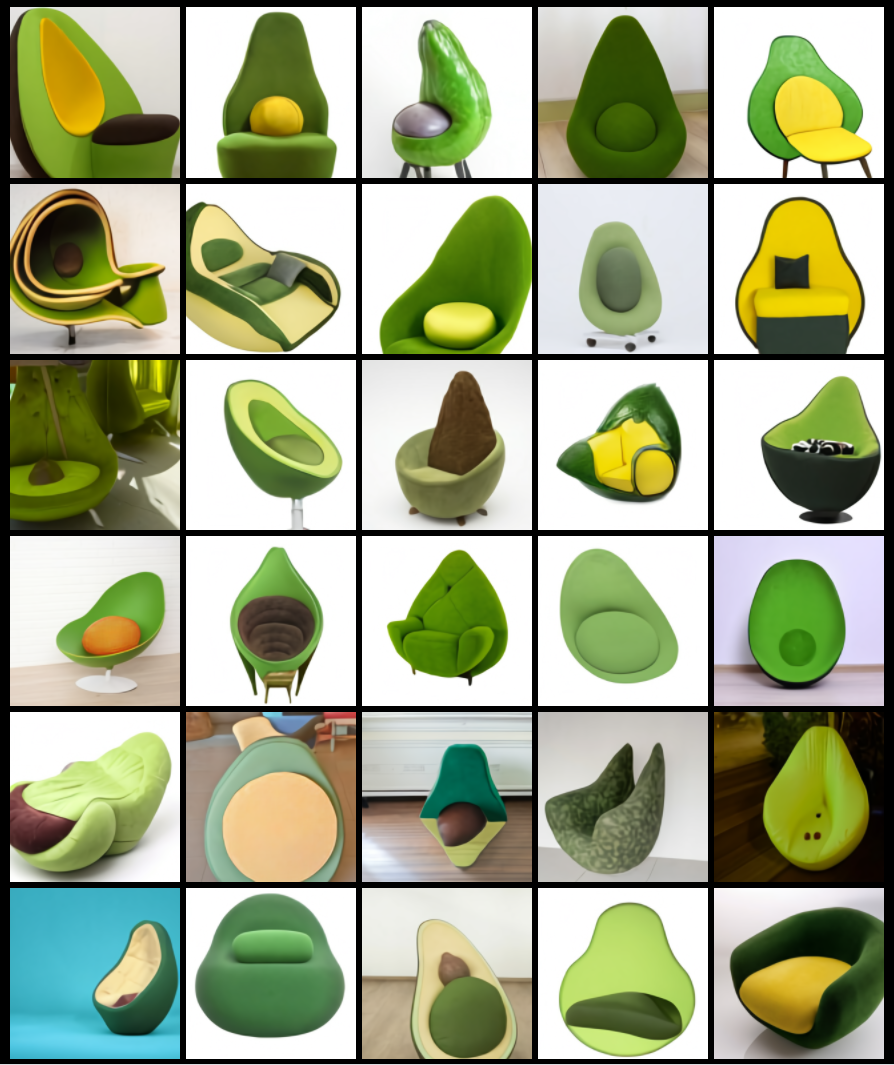

Op basis van de beeldendatabank krijgt het systeem vat op hoe bepaalde concepten en voorwerpen eruit horen te zien, zoals onder andere fauteuils en avocado’s. En door het ‘begrijpende’ taalmodel dat erachter schuilt, is het in staat om niet alleen foto’s te genereren van nog meer fauteuils en avocado’s, maar ook van fauteuils in de vorm van avocado’s.

Is het einde aangebroken voor meubelontwerpers? Nee hoor. Het netwerk zal niet echt rekening houden met de fysische haalbaarheid van het ontwerp, maar het kan misschien wel dienen als inspiratiebron voor designers. Ondertussen zie ik de avocadofauteuil wel in mijn living passen. Wil iemand er eentje voor mij maken? Zelf ben ik er helaas te onhandig voor.